Когда-то в прошлой жизни у меня была внушительная PBN (как сейчас говорят) на Web 2.0 платформах, в основном, конечно, на Blogger.com — с очень хорошими показателями PR на мордах блогов (у некоторых моих блогспотов в те годы без спама был PageRank 7/10, у главной страницы Яндекса в те годы PR был такой же). С помощью этой сетки я накачивал вес и наливал link popularity для другой сетки — партнерских дропшипинг-магазинов под штаты.

Тогда можно было почти в одиночку и без каких-либо программно-аппаратных комплексов поддерживать такую себе мини-seo-империю в 200-300 блогов и 20-30 интернет-магазинчиков, занимая топы в Google, Yahoo и Bing. Но времена поменялись, Google захватил 95% поискового рынка в США, получил контроль за поведением 95-98% пользователей и перестало хватать базовой seo-оптимизации и своих PBN для топов в конкурентных нишах.

Где-то на рубеже 2010-12 года порог входа в топы Google вырос кратно, и пришлось забросить партнерские магазины и сетку блогов на Blogger.com / WordPress.com, вернувшись в рунет, где наоборот денег стало ощутимо больше, а работать по-прежнему проще. Я даже успел поработать Head of SEO на паре-тройке довольно жирных сайтов в России (от 500К трафика в сутки). Но один раз побывав в топах в бурже, хочется вернуться снова, а как это сделать без финансовых ресурсов и без команды? Надо просто запустить «бережливый стартап» (тм) — это когда у тебя денег нет, но ты очень хочешь быть модным стартапером.

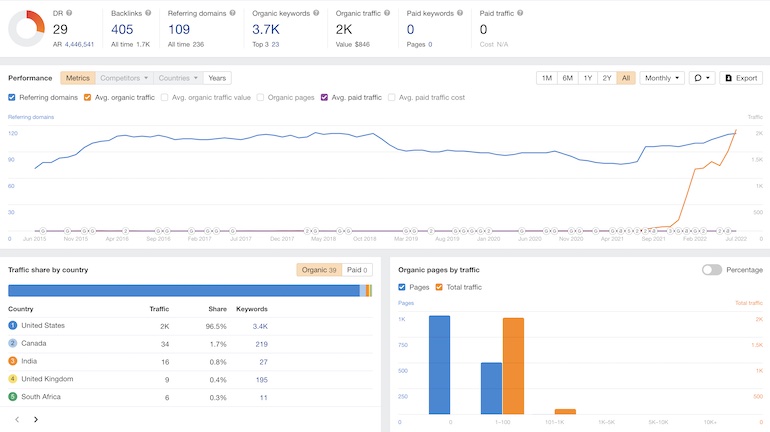

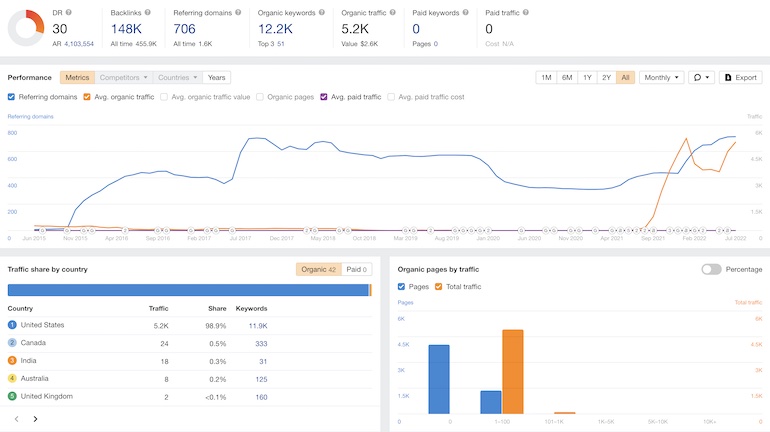

И вот вооружившись идеей бережливого стартапа я стал смотреть, что осталось от былой роскоши? А осталось несколько жирных дроп-доменов и несколько десятков блогов на Web 2.0 платформах — эти ресурсы я и решил привлечь к работе. На удивление, дропы за прошедшие 10 лет сменили 2 тематики, успели проваляться без сайтов лет 5, но в Google не забанены и не растеряли полностью ссылочную массу.

Да, бОльшая часть ссылок за 10 лет с них отвалилась, но DR остался всё равно: 30; 29; 17; 8 … понятно, что для возвращения к жизни этих дроп-доменов надо налить им ссылок, но чтобы купить ссылки в бурже нужны бюджеты на пару порядков больше, чем в рунете. Поэтому решил провести ревизию старых блогспот-блогов, поменять им тематику и обновить шаблоны (поставить адаптивные сразу, во-первых для нормального отображения на смартфонах, а во-вторых из-за Google Mobile-First index).

Прошелся, поменял шаблоны (выбирал самые простые, аскетичные и адаптивные из того, что есть в наборе бесплатных внутри админки Blogger.com), переименовал блоги под новую тематику, снес старые посты, добавил новых текстов (часть контента взял из архив.орг, часть контента — переводной), проставил ссылки на дропы и забыл на несколько месяцев. Обычно переиндексация происходила в Google очень быстро, а тут обнаружил, что где-то 20-30% блогов просто выпали из индекса, а остались только страницы архивных таксономий — типа таких https://svift.blogspot.com/2022/06/, страницы, которые отдают код 200 ОК, даже когда в них нет ни одной публикации.

В общем, бегло всё это похоже на бан или какие-то санкции, и я подумал, что причиной стала смена тематики / замена ссылок… приготовился похоронить идею выжать хоть что-то из блогов на Web 2.0 платформах. Но на всякий случай решил проверить индексацию своих старых персональных блогов на Web 2.0 платформах: https://svift.blogspot.com и https://svift.wordpress.com — а там ровно такая же картинка! Google выкинул из индекса 80% страниц старых сайтов на этих фри-блог-платформах. То есть причина оказалась не в смене тематики блогов, не в сквозных ссылках из блогроллов, похоже, что дело исключительно в том, что на блогах «1000 лет» не добавлялся новый контент, не появлялись комментарии, то есть сайты были просто заброшены и Гугл научился это понимать и выкидывать их из индекса (что-то похожее на алгоритм разметки Яндексом страниц как «Малоценная или маловостребованная страница» и выкидывания таких МПК-страниц из поиска (а если доля таких страниц больше определенного порога, то под фильтр в Яндексе улетает весь сайт).

Как я решил проблемы индексации блогов на Web 2.0 платформах?

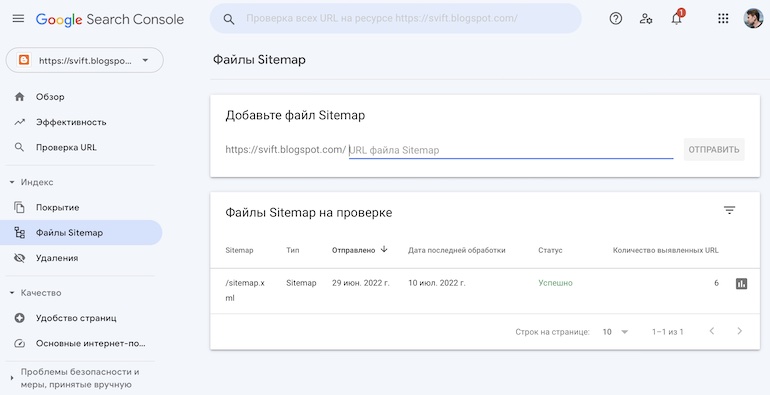

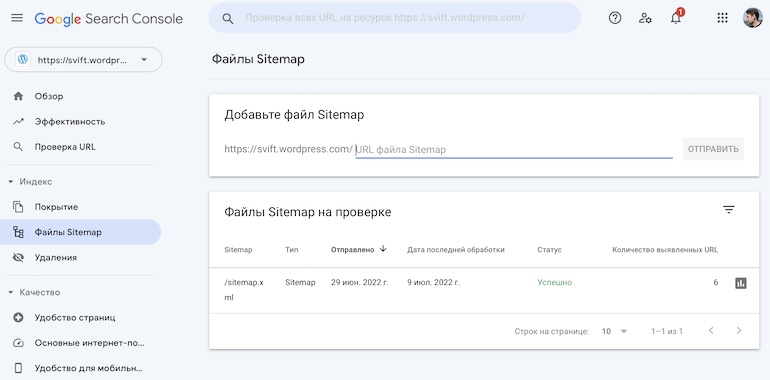

Во-первых, удалил все действительно «протухшие посты», контент на которых уже точно никогда не будет полезным, и даже с большой натяжкой его таком назвать нельзя. Зарегистрировал все эти Web 2.0 блоги в Google Search Console, включил на всех блогах XML карты сайтов и подал sitemap.xml в гугловом кабинете вебмастера.

Через пару недель страницы вернулись в индекс Google, проиндексировались и новые публикации, так что в итоге проблемы индексации блогов на Web 2.0 платформах решились с помощью Google Search Console.

Для профилактики решил время от времени публиковать посты на каждом из блогов, а также добавлять хотя бы раз в квартал по одному комментарию к каждой новой записи, чтобы в глазах Google эти блогспоты не выглядели брошенными. К слову, в Бинге и Яндексе проблем с индексацией этих вебдванольных блогов не было.